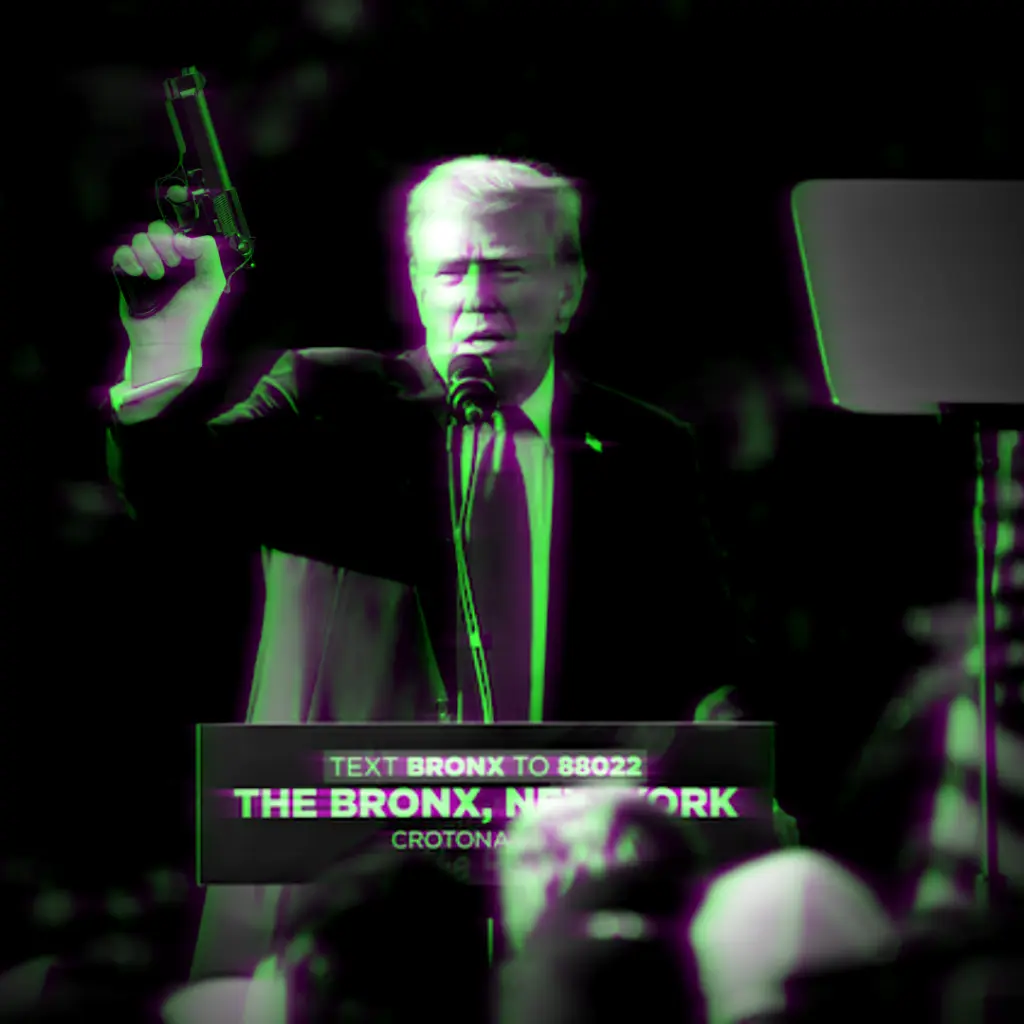

في العصر الرقمي، أصبح من الصعب بشكل متزايد التمييز بين ما هو حقيقي وما هو مزيف. وأثار ظهور التزييف العميق (deepfake) الدهشة والقلق. في حين أن التزييف العميق لديه القدرة على إحداث ثورة في حياتنا، فإنه يشكل أيضًا مخاطر كبيرة على المجتمع، بما في ذلك انتشار المعلومات الخاطئة والمضللة. فكيف نستطيع كشف التزييف العميق

يطور سوبرامانيان، خبير الذكاء الاصطناعي والأمن، نماذج تعتمد على التعلم الآلي لتحليل البيانات، وتعلم النماذج السلوكية من البيانات، والتنبؤ بالإجراءات والتأثير على النتائج. وفي منتصف عام 2024، أطلق نظام الكشف عن التزييف العميق العالمي عبر الإنترنت (GODDS)، وهي منصة جديدة للكشف عن التزييف العميق، وهي متاحة الآن لعدد محدود من الصحفيين المعتمدين.

وبالنسبة لأولئك الذين ليس لديهم إمكانية الوصول إلى (GODDS)، فقد جمعت Northwestern Now خمس نصائح من سوبرامانيان لمساعدتك على تجنب التعرض للخداع بواسطة التزييف العميق. في هذا المقال سنذكر هذه النصائح.

محتويات المقال :

ما هو التزييف العميق؟

التزييف العميق هو عبارة عن صور أو مقاطع فيديو أو مقاطع صوتية يتم تحريرها أو إنشاؤها باستخدام أدوات الذكاء الاصطناعي. ويمكنها تصوير أشخاص حقيقيين أو غير موجودين وهي نوع من الوسائط الاصطناعية. ويتم إنشاء التزييف العميق باستخدام تقنية التعلم الآلي المسماة التعلم العميق (deep learning). تتمكن خوارزميات التعلم العميق من تعلم أنماط معقدة من كميات كبيرة من البيانات. وهذا يسمح لها بإنشاء تزييف عميق واقعي المظهر قد يكون من الصعب تمييزه عن المحتوى الحقيقي.

إيجابيات وسلبيات

لقد تم استخدام محتوى التزييف العميق لخداع المشاهدين ونشر الأخبار المزيفة وزرع المعلومات المضللة وإدامة الخدع عبر الإنترنت.

ولكن ما لا يدركه الكثيرون هو أن التكنولوجيا التي تقوم عليها هذه التقنية يمكن استخدامها أيضا بطريقة إيجابية. فيمكن استخدامها لإعادة إنتاج صوت أحد الأحباء الذيت توفوا، على سبيل المثال، أو لزرع خرائط أو اتصالات مزيفة لتضليل الإرهابيين المحتملين. ويمكنها أيضا أن تكون ترفيهية، على سبيل المثال، من خلال محاكاة شكل شخص ما بشعر وجه غريب أو يرتدي قبعة مضحكة.

ويمكن استخدامها أيضًا لإنشاء عمليات محاكاة تساعد الأشخاص على تعلم مهارات جديدة أو ممارسة المهام المعقدة في بيئة آمنة. على سبيل المثال، يمكن لطلاب الطب استخدام عمليات المحاكاة التي يولدها الذكاء الاصطناعي لممارسة العمليات الجراحية، مما يقلل من خطر إيذاء المرضى الحقيقيين.

العلم وراء التزييف العميق

تعتمد تقنية التزييف العميق في جوهرها على نوع من الذكاء الاصطناعي يسمى النموذج المولد (Generative model). يتم تدريب هذه النماذج على مجموعات بيانات كبيرة من الصور أو مقاطع الفيديو أو الملفات الصوتية، مما يمكنها من تعلم الأنماط والعلاقات داخل البيانات. ثم يستخدم الذكاء الاصطناعي هذه المعرفة لإنشاء محتوى اصطناعي جديد يحاكي البيانات الأصلية.

أحد الأنواع الشائعة من النموذج المولد هو شبكة الخصومة التوليدية (GAN). تتكون شبكات (GAN) من شبكتين عصبيتين تتنافسان لإنشاء صور مزيفة واقعية. تقوم الشبكة الأولى، التي تسمى المولِّد، بإنشاء محتوى اصطناعي، بينما تقوم الشبكة الثانية، التي تسمى المُميِّز، بتقييم المحتوى الذي تم إنشاؤه وإخبار المولِّد ما إذا كان واقعيًا أم لا. تسمح هذه العملية ذهابًا وإيابًا للمولد بتحسين إنتاجه، وإنشاء مقاطع مزيفة مقنعة بشكل متزايد.

كما تم تعزيز ظهور التزييف العميق من خلال التقدم في رؤية الكمبيوتر والتعلم الآلي. لقد مكنت تقنيات مثل التعرف على الوجه، واكتشاف الأشياء، ونقل الأنماط من إنشاء أعمال فنية رقمية واقعية للغاية. على سبيل المثال، يسمح نقل النمط للذكاء الاصطناعي بأخذ وجه شخص ما وزرعه في جسد شخص آخر، مما يؤدي إلى إنشاء فيديو تزييف عميق مقنع.

كيف تكشف التزييف العميق وتحمي نفسك من الخداع؟

اسأل عما تراه وتسمعه

يمكن لأي شخص لديه إمكانية الوصول إلى الإنترنت إنشاء مقطع مزيف. وهذا يعني أن أي شخص لديه إمكانية الوصول إلى الإنترنت يمكن أن يصبح أيضًا هدفًا لعمليات التزييف العميق. وبدلاً من محاولة اكتشاف ما إذا كان شيء ما مزيفًا أم لا، يمكن أن يساعد التساؤل والتشكيك في التوصل إلى الاستنتاج الصحيح.

ابحث عن التناقضات

تستمر تقنية التزييف العميق والذكاء الاصطناعي في التطور بوتيرة سريعة. وفي النهاية، ستكون برامج الكمبيوتر قادرة على اكتشاف التزييف العميق بشكل أفضل من البشر.

ولكن في الوقت الحالي، هناك بعض أوجه القصور في تقنية التزييف العميق التي يمكن للبشر اكتشافها. لا يزال الذكاء الاصطناعي يكافح مع أساسيات جسم الإنسان، ويضيف أحيانًا إصبعًا إضافيًا أو يشوه الأجزاء بطرق غير طبيعية أو مستحيلة. كما يمكن أن تتسبب فيزياء الضوء أيضًا في تعثر مولدات الذكاء الاصطناعي.

التحرر من التحيزات

غالبًا ما يبحث الناس عن مصادر تؤكد مفاهيمهم الخاصة، ويقوم المحتالون بإنشاء مقاطع فيديو مزيفة تعمل على تعزيز وتأكيد المعتقدات السابقة لتحقيق أهدافهم الخاصة. فعندما يقوم الناس برفض الجزء المنطقي من أدمغتهم لأن شيء ما يتوافق مع معتقداتهم، فإنهم يكونون أكثر عرضة للوقوع فريسة للتزييف العميق.

إعداد تدابير المصادقة

يمكن استخدام مقاطع الصوت المزيفة لخداع الناس وسرقة أموالهم. فإذا اتصل شخص يبدو وكأنه صديق مقرب أو قريب ويقول إنه يحتاج إلى المال بسرعة للخروج من مأزق، فقد يكون ذلك مزيفًا.

لتجنب الوقوع في هذه الخدعة، عليك إعداد طرق للمصادقة مع أحبائك. قم بطرح أسئلة محددة يعرفها هذا الشخص فقط، مثل المكان الذي ذهبوا لتناول الغداء فيه مؤخرًا أو الحديقة التي لعبوا فيها كرة القدم ذات يوم. يمكن أن تكون حتى كلمة مرور يعرفها الأقارب فقط.

اعلم أن منصات التواصل الاجتماعي لا تستطيع فعل الكثير

عليك أن تدرك أن منصات التواصل الاجتماعي لا يمكنها أن تفعل الكثير لمنع التزييف العميق. خذ زمام المبادرة للتحقق من المعلومات واستشارة المصادر ذات السمعة الطيبة مثل (PolitiFact) لضمان صحة ما تشاهده.

المصدر

سعدنا بزيارتك، جميع مقالات الموقع هي ملك موقع الأكاديمية بوست ولا يحق لأي شخص أو جهة استخدامها دون الإشارة إليها كمصدر. تعمل إدارة الموقع على إدارة عملية كتابة المحتوى العلمي دون تدخل مباشر في أسلوب الكاتب، مما يحمل الكاتب المسؤولية عن مدى دقة وسلامة ما يكتب.

التعليقات :