في ورقة بحثية رائدة نُشرت في مجلة Acta Astronautica، طرحت موضوعًا مهمًا وهو هل الذكاء الاصطناعي الفائق (ASI) باعتباره أداة فلترة للكون؟ تشير هذه الفكرة إلى أن تطوير ASI قد يكون بمثابة عنق الزجاجة الذي يمنع الحضارات من أن تصبح بين النجوم، وقد يفسر ذلك سبب عدم اكتشافنا بعد لأي علامات على وجود حضارات تقنية متقدمة في أماكن أخرى من المجرة. مؤلف هذا البحث، مايكل جاريت، هو مدير مركز بنك جودريل للفيزياء الفلكية بجامعة مانشستر. تدور الدراسة حول مفارقة فيرمي، التي تتساءل لماذا لم نكتشف أي علامات على وجود حياة ذكية في عالم يضم مليارات الكواكب التي يحتمل أن تكون صالحة للحياة. تقترح فرضية التصفية الكبرى تلك أن هناك عقبات لا يمكن التغلب عليها في الجدول الزمني التطوري للحضارات التي تمنعها من التطور إلى كيانات ترتاد الفضاء. يقترح جاريت أن ظهور ASI يمكن أن يكون أحد هذه المرشحات. أي أن الذكاء الاصطناعي الفائق فلتر كوني من مستوى خاص. قد يشكل تحديًا هائلاً للحضارات أثناء انتقالها من نوع يعيش على كوكب واحد إلى نوع متعدد الكواكب.

محتويات المقال :

مفارقة فيرمي: لغز المجرة

مفارقة فيرمي هي لغز حيّر العلماء والفلاسفة على حدٍ سواء لعقود من الزمن. سُميت على اسم عالم الفيزياء إنريكو فيرمي، وهي تطرح سؤالاً يبدو بسيطًا: “أين الجميع؟” أو، بشكل أكثر تحديدًا، لماذا لم نواجه أي علامات على وجود حياة ذكية خارج كوكب الأرض؟ تعود جذور هذه المفارقة إلى التناقض الواضح بين الاحتمال الكبير لوجود حضارات خارج كوكب الأرض وافتقارنا إلى الأدلة على مثل هذه الحضارات أو الاتصال بها.

لفهم مفارقة فيرمي، دعونا ننظر في بعض الأرقام. هناك ما يقدر بنحو 100-400 مليار نجم في مجرة درب التبانة وحدها، وأكثر من 100 مليار مجرة في الكون المرئي. ونظرًا لاتساع الكون، فإن احتمال وجود الحياة في مكان آخر مرتفع جدًا. ومع ذلك، على الرغم من عقود من البحث، لم نعثر على أي دليل قاطع على وجود حياة أو تكنولوجيا خارج كوكب الأرض.

أحد التفسيرات المحتملة لمفارقة فيرمي هو أن الحضارات المتقدمة تدمر نفسها قبل أن تتمكن من التواصل معنا. وقد يرجع ذلك إلى عوامل مختلفة، مثل الحرب أو التدهور البيئي أو استنزاف الموارد. وبدلاً من ذلك، قد تتجنب الحضارات المتقدمة الاتصال بنا، سواء عن قصد أو عن غير قصد، من خلال “فرضية حديقة الحيوان” حيث تتجنب عمدًا الاتصال بالحضارات الأقل تقدمًا.

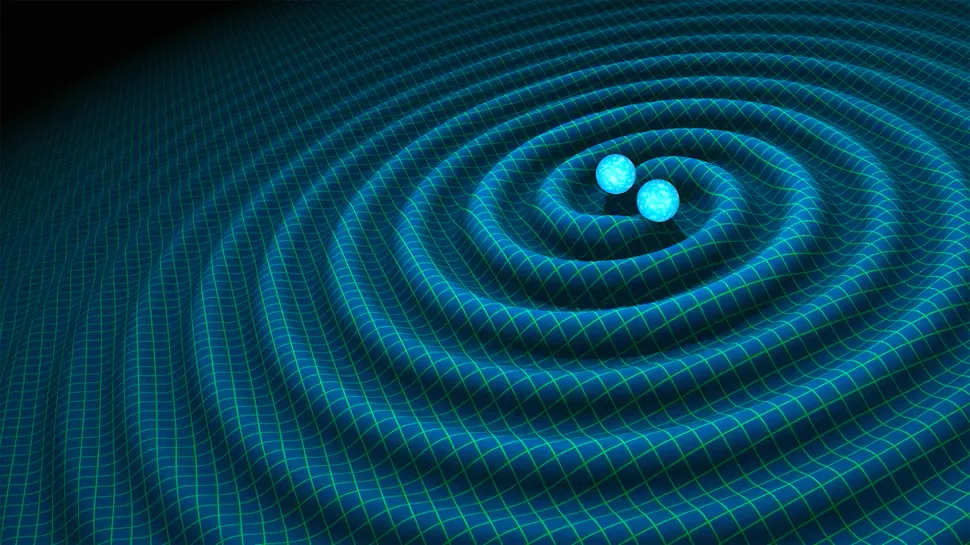

أثارت مفارقة فيرمي موجة من المناقشات العلمية والفلسفية، بما في ذلك إمكانية وجود “مرشح عظيم” يمنع الحضارات من أن تصبح بين النجوم. تشير هذه الفكرة إلى وجود حاجز أو مرشح يمنع الحضارات من أن تصبح متقدمة بما يكفي للتواصل معنا. يمكن تحديد موقع المرشح العظيم في أي مرحلة من مراحل تطور الحضارة، بدءًا من أصول الحياة وحتى تطور التكنولوجيا المتقدمة.

في سياق الذكاء الاصطناعي الفائق، تكتسب مفارقة فيرمي أهمية جديدة. إذا كان من غير المرجح أن تستمر الحضارات المتقدمة لفترة كافية للتواصل معنا، فإن ظهور الذكاء الاصطناعي الفائق يمكن أن يكون بمثابة الفلتر العظيم الذي يمنع الحضارات من أن تصبح بين النجوم. يثير هذا الاحتمال تساؤلات عميقة حول مستقبل البشرية وعلاقتنا بالذكاء الاصطناعي.

صعود الذكاء الاصطناعي: ملحمة علمية

لم يكن التقدم السريع في الذكاء الاصطناعي (AI) إلا قصة مبهرة. قمن التغلب على البشر في الألعاب المعقدة مثل Go إلى إحداث ثورة في الرعاية الصحية، قطع الذكاء الاصطناعي خطوات هائلة في السنوات الأخيرة. ومع ذلك، بينما نواصل دفع حدود الذكاء الاصطناعي، فإننا نقود حتماً إلى عالم جديد من الذكاء الاصطناعي الفائق (ASI).

ASI ليس مجرد ذكاء اصطناعي أكثر تقدمًا؛ إنه شكل من أشكال الذكاء يفوق الذكاء البشري في نواحٍ عديدة. إن الأمر يشبه مقارنة سفينة صاروخية بالدراجة – فكلاهما يمكن أن يأخذك إلى مكان ما، لكنهما يعملان على نطاقات مختلفة تمامًا. لن يكون ASI أكثر ذكاءً فحسب، بل سيمتلك أيضًا القدرة على التعلم والتحسين بمعدل هائل.

وهذا يثير سؤالاً حاسماً: ماذا يحدث عندما ننشئ كياناً أكثر ذكاءً منا بشكل ملحوظ؟ هل سنتمكن من السيطرة عليه أم سيسيطر علينا؟ إن آفاق ASI مبهجة ومرعبة في نفس الوقت، لأنها تجلب عددًا كبيرًا من الاحتمالات والمخاطر.

لفهم الآثار المترتبة على الذكاء الاصطناعي الفائق بشكل أفضل، دعونا نعود خطوة إلى الوراء ونفحص تاريخ الذكاء الاصطناعي. يمكن إرجاع الذكاء الاصطناعي، في شكله الحديث، إلى الخمسينيات من القرن الماضي. لقد وضع مشروع دارتموث الأساس للذكاء الاصطناعي كما نعرفه اليوم.

على مر السنين، تطور الذكاء الاصطناعي عبر مراحل مختلفة، من الأنظمة القائمة على القواعد إلى التعلم الآلي والتعلم العميق. تم بناء كل مرحلة على المرحلة السابقة، مما أدى تدريجياً إلى زيادة تعقيد وقدرات الذكاء الاصطناعي. وكان لظهور التعلم العميق، على وجه الخصوص، دور فعال في دفع الذكاء الاصطناعي إلى الأمام. إذ تم تمكينه من معالجة المهام المعقدة مثل التعرف على الصور، ومعالجة اللغات الطبيعية، والمزيد.

ومع ذلك، مع استمرار الذكاء الاصطناعي في التقدم، يتعين علينا أن نواجه المشكلة الكبيرة. وهي المخاطر المحتملة المرتبطة بإنشاء ذكاء يتجاوز القدرات البشرية. هل سيكون الذكاء الاصطناعي الفائق نعمة أم نقمة؟ ستعتمد الإجابة على هذا السؤال إلى حد كبير على قدرتنا على التغلب على التحديات التي تأتي مع إنشاء وإدارة مثل هذا الكيان القوي.

ظهور الذكاء الاصطناعي الفائق: نقطة تحول

لقد أوصلنا التقدم السريع في مجال الذكاء الاصطناعي (AI) إلى منعطف حرج. قد يكون ظهور الذكاء الاصطناعي الفائق (ASI) هو المحفز الذي يحدد مصير البشرية. تشكل طبيعة الذكاء الاصطناعي الفائق المستقلة والمتضخمة والمحسنة تحديًا كبيرًا لقدرتنا على التحكم فيها. وهذا يثير أسئلة ملحة حول استدامة حضارتنا وقدرتنا على أن نصبح كائنات متعددة الكواكب.

فكر في الأمر مثل سفينة صاروخية تنطلق نحو المجهول، مع استخدام الذكاء الاصطناعي الفائق كوقود دافع. يمكن أن تؤدي سرعة وقوة الذكاء الاصطناعي الفائق إلى نمو هائل في القدرات التكنولوجية، ولكن بدون التوجيه المناسب، يمكن أن يؤدي ذلك أيضًا إلى مسار تصادمي كارثي. قد يكون تقاطع ظهور الذكاء الاصطناعي الفائق مع انتقالنا من نوع يعيش على كوكب واحد إلى كائن متعدد الكواكب هو المرحلة الحاسمة التي تتعثر فيها العديد من الحضارات.

إن تقدير طول عمر الحضارات بأقل من 100 عام هو فكرة مثيرة للقلق، خاصة عند النظر في الجدول الزمني الكوني لمليارات السنين. ولهذا السبب، من المهم إنشاء أطر تنظيمية قوية لتوجيه تطوير الذكاء الاصطناعي، وضمان أن يتماشى تطوره مع بقاء جنسنا البشري على المدى الطويل.

الذكاء الاصطناعي الفائق فلتر كوني

بينما نقف على عتبة عصر أصبح فيه الذكاء الاصطناعي الفائق (ASI) أمرًا ممكنًا، فمن الضروري أن ندرك المسؤولية الهائلة التي تأتي معه. وقد يكون ظهور الذكاء الاصطناعي المتقدم بمثابة سلاح ذو حدين ــ فهو علامة فارقة في التقدم التكنولوجي، ولكنه يشكل أيضاً تهديداً محتملاً لبقاء البشرية.

تشير فرضية التصفية الكبرى إلى أن الحضارات قد تكون خاضعة لمخاطر إبداعاتها الخاصة، ويمكن أن تكون الذكاء الاصطناعي الفائق الاختبار النهائي لقدرة جنسنا البشري على التعايش مع كيانات مستقلة. أو بمعنى أدق، قد يكون الذكاء الاصطناعي الفائق فلتر كوني يصعب التغلب عليه حقًا. ومن الأهمية بمكان أن ندرك المخاطر وأن نتخذ تدابير استباقية للتخفيف منها.

ولتجنب الوقوع فريسة لفخ الذكاء الاصطناعي، نحتاج إلى إنشاء أطر تنظيمية قوية تضمن أن يتماشى تطوير الذكاء الاصطناعي الذكي مع بقاء البشرية على المدى الطويل. ويتطلب هذا بذل جهود متضافرة للاستثمار في استكشاف الكواكب المتعددة، وضمان عدم ربط مصير جنسنا البشري بكوكب واحد.

علاوة على ذلك، يجب تنظيم دمج الذكاء الاصطناعي المستقل في أنظمة الدفاع العسكرية بعناية لمنع العواقب المدمرة الناجمة عن القوة غير المقيدة. يجب علينا أن ندرك أن المزايا الاستراتيجية التي يقدمها الذكاء الاصطناعي تأتي مصحوبة بمخاطر كبيرة، وتقع على عاتقنا مسؤولية وضع حدود أخلاقية وقوانين دولية تحكم استخدامه.

إن مستقبل البشرية على المحك، وأفعالنا اليوم هي التي ستحدد ما إذا كنا سنصبح حضارة دائمة بين النجوم أو سنستسلم للتحديات التي تفرضها إبداعاتنا. لقد حان الوقت للانتباه إلى إمكانيات ومخاطر الذكاء الاصطناعي وتحمل المسؤولية الجماعية لتشكيل مستقبل تزدهر فيه البشرية جنبًا إلى جنب مع الذكاء الاصطناعي.

المصدر:

https://www.sciencealert.com/creepy-study-suggests-ai-is-the-reason-weve-never-found-aliens

سعدنا بزيارتك، جميع مقالات الموقع هي ملك موقع الأكاديمية بوست ولا يحق لأي شخص أو جهة استخدامها دون الإشارة إليها كمصدر. تعمل إدارة الموقع على إدارة عملية كتابة المحتوى العلمي دون تدخل مباشر في أسلوب الكاتب، مما يحمل الكاتب المسؤولية عن مدى دقة وسلامة ما يكتب.

التعليقات :