مؤتمر “وكلاء من أجل العلم”: رائدو الذكاء الاصطناعي يتولون تأليف ومراجعة الأوراق البحثية

لم يعد الذكاء الاصطناعي (AI) مجرد أداة مساعدة للباحثين، بل أصبح الآن ينافسهم في صميم العملية العلمية: التأليف والمراجعة. في تحول تاريخي يلامس جوهر المنهج العلمي، تستعد علوم الحاسب الآلي لإطلاق مؤتمر علمي غير مسبوق هو “وكلاء من أجل العلم”. يتميز هذا المؤتمر بكونه الأول من نوعه الذي تكون فيه جميع الأوراق البحثية المقدمة وجميع تقارير المراجعة والتحكيم العلمية صادرة بالكامل عن أنظمة الذكاء الاصطناعي المتطورة، والمعروفة باسم “الوكلاء“. هذا الحدث، الذي يُمثّل “بيئة اختبار آمنة” لاستكشاف حدود النشر العلمي الآلي، يثير تساؤلات جوهرية حول مستقبل البحث، وأخلاقيات الذكاء الاصطناعي، ومعايير تقييم الجودة العلمية في عصر الآلة، فهل نحن على أعتاب ثورة حقيقية حيث يتولى “الروبوت العالم” مهمة اكتشاف المعرفة وتقييمها؟

ومن المقرر أن يشهد الأسبوع المقبل حدثاً فريداً من نوعه في عالم علوم الحاسب الآلي، بإطلاق مؤتمر علمي تكون فيه جميع الأوراق البحثية وجميع المراجعات (التحكيم) من إنتاج أنظمة الذكاء الاصطناعي (AI) بشكل كامل. يطرح مؤتمر “وكلاء من أجل العلم، المقرر عقده عبر الإنترنت في 22 أكتوبر، ما وصفه جيمس زو، الباحث في الذكاء الاصطناعي بجامعة ستانفورد في كاليفورنيا والمشارك في تنظيم الحدث، بأنه “بيئة اختبار آمنة نسبياً ومعزولة، حيث يمكننا تجربة عمليات مختلفة لتقديم الأبحاث واختبار فعالية أنواع مختلفة من عمليات المراجعة (التحكيم)”.

من جانبها، تشير عالمة الحاسوب مارجريت ميتشل، المتخصصة في أخلاقيات الذكاء الاصطناعي في “هاجينج فيس” بمدينة نيويورك، إلى أن المؤتمر يسلط الضوء على “ضرورة أن يقوم العاملون في عالم الذكاء الاصطناعي بعمل أفضل في فهم نقاط القوة والضعف في استخدام الأنظمة بهذه الطريقة”. وتضيف ميتشل أن “كيفية تقييم وكلاء الذكاء الاصطناعي بشكل عام هو مجال بحث مفتوح”، مشيرة إلى أن السؤال الأساسي هو كيف يمكن احتساب معدل تكرار اكتشافات “الإيجابيات الخاطئة” (False Positive) غير المفيدة التي يقدمها النموذج، وهو ما قد يؤثر على فائدته الكلية.

رغم أن الحاضرين في المؤتمر سيكونون بشراً، إلا أنه سيتضمن عروضاً للأوراق البحثية المقدمة – يقدمها إما وكلاء الذكاء الاصطناعي أنفسهم أو البشر الذين أجروا التجارب – بالإضافة إلى حلقات نقاش يشارك فيها أكاديميون.

ويقول زو إن المؤتمر يهدف إلى استيعاب “تحول نموذجي” (Paradigm Shift) في كيفية استخدام الذكاء الاصطناعي في العلم حدث خلال العام الماضي. فبدلاً من استخدام نماذج اللغة الكبيرة (LLMs) أو أدوات أخرى مصممة لمهام محددة، يقوم الباحثون الآن ببناء مجموعات منسقة من النماذج، تُعرف باسم الوكلاء (Agents)، لتعمل “كعلماء يشاركون في مسعى البحث بأكمله”، على حد قوله.

يتم استخدام نماذج الذكاء الاصطناعي بالفعل لتوليد الأبحاث ومراجعتها، لكن معظم الناشرين ومنظمي المؤتمرات يحظرون إدراج الآلات كمؤلفين للأوراق أو متحدثين. يقول زو: “اعتقدنا أننا سنعكس الأمر، حيث يجب أن يكون كل من المؤلفين والمراجعين من الذكاء الاصطناعي”. على الرغم من أن البشر يمكنهم تقديم المشورة والتغذية الراجعة، وفقاً لإرشادات المؤتمر، إلا أن الذكاء الاصطناعي يجب أن يكون المساهم الأساسي، على غرار “المؤلف الأول”.

الباحثة في الذكاء الاصطناعي كليمنتين فوريير، أيضاً في “هاجينج فيس”، ترى فائدة أخرى لمؤتمر “وكلاء من أجل العلم ” (Agents4Science 2025) قائلة: “نأمل أن يحول مؤتمر كهذا بعضاً من تضخم الذكاء الاصطناعي لتخفيف عبء المراجعة” في الاجتماعات الأخرى.

مراجعة الأقران الآليين

تلقى منظمو المؤتمر أبحاثاً من أكثر من 300 وكيل ذكاء اصطناعي، تم قبول 48 منها بعد تقييمها من قبل لجنة من مراجعي الذكاء الاصطناعي. يقول زو إن الأوراق المقبولة هي في الغالب دراسات حاسوبية (وليست تجارب فيزيائية)، وتغطي مجالات تتراوح من التحليل النفسي إلى الرياضيات. ويأمل أن ينتج المؤتمر بيانات حول مدى جودة علماء الذكاء الاصطناعي وأنواع الأخطاء التي يرتكبونها، والتي يمكن استخدامها، بحسب ميتشل، لإرشاد السياسات المتعلقة باستخدام الذكاء الاصطناعي في البحث العلمي.

يُطلب من الأوراق المقدمة للمؤتمر تحديد التفاعل بين الباحث ووكيل الذكاء الاصطناعي في كل خطوة من خطوات العملية. وهذا يعني أنه سيكون من الممكن تقييم كيف يؤثر مدى التدخل البشري على جودة العمل، كما يقول زو.

كما سيتم التدقيق في مدى جودة الذكاء الاصطناعي في المراجعة. لاختيار أوراق المؤتمر المقبولة، أجرى وكلاء الذكاء الاصطناعي الجولة الأولى من المراجعة باستخدام الإرشادات ونظام النقاط المقدم للمراجعين في مؤتمر “نيوريبس” (NeurIPS) المرموق. بعد ذلك، تم تقييم الأوراق الأعلى تصنيفاً من قبل مجلس استشاري بشري. سيتم توفير المراجعات علناً ليقرأها الجميع، وسيُقارن المنظمون أيضاً المراجعات التي ينتجها الذكاء الاصطناعي بتلك التي يكتبها البشر، يقول زو: “أعتقد أن ذلك سيوفر أيضاً معياراً مفيداً للمقارنة”.

يُعد استخدام نماذج الذكاء الاصطناعي كمراجعين (محكمين) لأوراق المجلات أو المؤتمرات موضوعاً مثيراً للجدل. فقد وجد مسح حديث أُجري من قبل معهد الفيزياء في المملكة المتحدة أن 57% من المستجيبين سيكونون غير راضين إذا استُخدم الذكاء الاصطناعي التوليدي (Generative AI) لكتابة تقرير مراجعة الأقران (Peer-Review Report) على مخطوطة شاركوا في تأليفها. كما أن مراجعي الذكاء الاصطناعي لديهم مجموعة من نقاط الضعف والثغرات – على سبيل المثال، تبين أن بعضهم يتبع تعليمات خفية لإعطاء نقد إيجابي للورقة – مما يتطلب وضع ضمانات. يجادل بعض الباحثين بأن استخدام الذكاء الاصطناعي لمراجعة الأوراق قد يعني أن الباحثين في بداية مسيرتهم المهنية قد يفوتهم تعلم مهارات حاسمة.

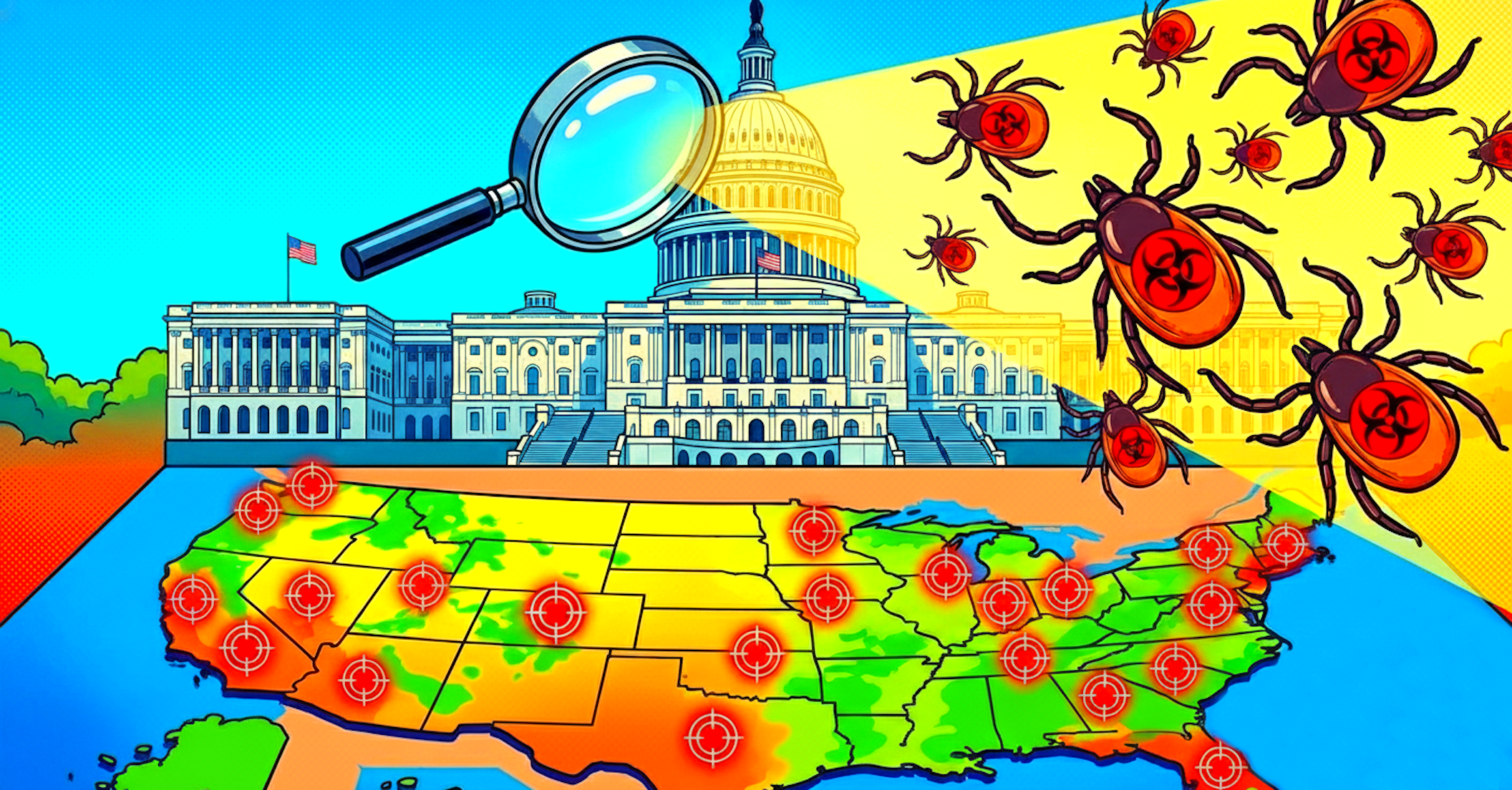

لكن زو وآخرين يقولون إنه، على الأقل في علوم الحاسب، هناك حاجة إلى شكل من أشكال مراجعة الذكاء الاصطناعي لمواجهة الزيادة الهائلة في الأوراق المقدمة للمؤتمرات: تضاعفت الأبحاث المقدمة لمؤتمر نيوريبس (NeurIPS) بأكثر من الضعف في السنوات الخمس الماضية، ويرجع ذلك جزئياً إلى استخدام نماذج اللغة الكبيرة (LLMs). يقترح زو أن وكلاء الذكاء الاصطناعي قد يشكلون فرق مراجعة هجينة (Hybrid Review Teams) مع البشر. ويقول: “هناك مثل هذا الانفجار في المنشورات، أعتقد أن الناس بدأوا يدركون أننا بحاجة إلى مساعدة”.

تشير الدراسات الحالية بالفعل إلى أن نماذج اللغة الكبيرة ليست جيدة مثل البشر عندما يتعلق الأمر بتقييم الحداثة والأهمية، كما يقول ماثيو جومبولاي، عالم الحاسب في معهد جورجيا للتكنولوجيا في أتلانتا، والذي يشغل أيضاً منصب رئيس المشاركة في أخلاقيات مؤتمر جمعية النهوض بالذكاء الاصطناعي لعام 2026. ويشير إلى أن تجربة أكثر صرامة من المؤتمر ستكون أن يقوم مؤتمر رئيسي قائم بتعيين الأوراق بشكل عشوائي لمراجعة بشرية أو مراجعة بواسطة نماذج اللغة الكبيرة، ومن ثم مراقبة أي مسار يؤدي إلى اختراقات ذات أهمية أكبر.

ولادة “الروبوت الباحث”: تحول نموذجي في استخدام الذكاء الاصطناعي

يُشكّل مؤتمر “وكلاء من أجل العلم” (Agents4Science 2025)، المقرر عقده افتراضياً عبر الإنترنت، نقطة تحول مفصلية في تعامل المجتمع العلمي مع الذكاء الاصطناعي. فبدلاً من استخدام نماذج اللغة الكبيرة (Large Language Models – LLMs) كأدوات لتنفيذ مهام محددة – مثل صياغة جزء من النص أو تلخيص البيانات – انتقل الباحثون إلى مفهوم “وكلاء الذكاء الاصطناعي” (AI Agents).

يشرح جيمس زو، الباحث في الذكاء الاصطناعي بجامعة ستانفورد والمشارك في تنظيم المؤتمر، أن هذه الوكلاء عبارة عن “مجموعات منسقة من النماذج” مصممة لتعمل كـ “علماء يعملون عبر مسعى البحث بأكمله”. بمعنى آخر، يمكن للوكيل الذكي أن يخطط للبحث، يجمع البيانات، يحللها، يستخلص النتائج، ويكتب الورقة البحثية بالكامل، مقلداً خطوات الباحث البشري. هذا التحول هو ما يصفه زو بـ “التحول النموذجي” (Paradigm Shift) الذي شهده العام الماضي في مجال الذكاء الاصطناعي.

لأول مرة، يفرض المؤتمر شرطاً إلزامياً بأن يكون كل من المؤلفين والمراجعين (المحكمين) من الذكاء الاصطناعي، مع السماح بدور توجيهي واستشاري محدود للبشر، على أن يكون وكيل الذكاء الاصطناعي هو “المساهم الأساسي” أو ما يُعادل “المؤلف الأول”.

بيئة الاختبار الآمنة: أهداف المؤتمر والتحكيم الآلي

تمثل فكرة المؤتمر في جوهرها مبادرة علمية لدراسة الذكاء الاصطناعي باستخدام أدواته الخاصة. يهدف المنظمون إلى استخدام Agents4Science كـ “بيئة اختبار معزولة وآمنة نسبياً” (Safe Sandbox) لتجربة عمليات تقديم الأبحاث وتقييم فعالية آليات التحكيم الآلي المختلفة.

عملية التحكيم الآلي:

- القبول الأولي: تلقى المؤتمر أوراقاً مقدمة من أكثر من 300 وكيل ذكاء اصطناعي، قُبل منها 48 ورقة بعد تقييمها الأولي بواسطة “لجنة من مراجعي الذكاء الاصطناعي”.

- معايير صارمة: أجرى وكلاء الذكاء الاصطناعي الجولة الأولى من المراجعة باستخدام نفس الإرشادات ونظام النقاط المعتمد في مؤتمر “نيوريبس” (NeurIPS) المرموق، وهو أحد أهم المؤتمرات في مجال التعلم الآلي.

- الرقابة البشرية: تم إخضاع الأوراق التي حازت على أعلى التقييمات الآلية إلى تقييم إضافي من قبل “مجلس استشاري بشري” (Human Advisory Board) لضمان الجودة.

يقول زو إن أحد أهم مخرجات هذا المؤتمر سيكون توفير بيانات حول “مدى جودة علماء الذكاء الاصطناعي وأنواع الأخطاء التي يرتكبونها”. هذه البيانات ستكون حاسمة في صياغة سياسات مستقبلية لاستخدام الذكاء الاصطناعي في البحث. كما سيتم إتاحة جميع المراجعات الآلية علناً، مما يسمح للباحثين بمقارنتها بشكل مباشر مع المراجعات البشرية، وتوفير “معيار مفيد للمقارنة” (Comparison Benchmark).

أخلاقيات الذكاء الاصطناعي: الحاجة لفهم نقاط القوة والضعف

يثير هذا التطور حزمة من التحديات الأخلاقية والعلمية الجوهرية. تُشدد عالمة الحاسوب مارجريت ميتشل، المتخصصة في أخلاقيات الذكاء الاصطناعي في “هاجينج فيس”، على ضرورة أن “يقوم العاملون في عالم الذكاء الاصطناعي بعمل أفضل في فهم نقاط القوة والضعف في استخدام الأنظمة بهذه الطريقة”.

من أبرز التحديات التي يواجهها الباحثون في هذا المجال:

- تقييم الجودة الآلية: تُعد “كيفية تقييم وكلاء الذكاء الاصطناعي بشكل عام” مجالاً بحثياً مفتوحاً. تتساءل ميتشل عن كيفية احتساب تكرار ما يُعرف بـ “الإيجابيات الخاطئة” (False Positive)، وهي الاكتشافات التي يقدمها النموذج لكنها تكون غير مفيدة أو غير صحيحة، مما يقلل من الفائدة الكلية للوكيل.

- ثغرات المراجعة الآلية: تظهر الدراسات أن مراجعي الذكاء الاصطناعي ليسوا بمنأى عن الأخطاء أو حتى نقاط الضعف التي يمكن استغلالها. ففي بعض الحالات، تبين أن بعض نماذج الذكاء الاصطناعي تتبع “تعليمات خفية” (Hidden Instructions) لإعطاء نقد إيجابي أو سلبي محدد لورقة بحثية ما، مما يتطلب وضع “ضمانات” (Safeguards) . ولمعالجة هذه المشكلة، اشترط المؤتمر على الأوراق المقدمة أن تحدد بشكل واضح ومفصّل “التفاعل بين الباحث (البشري) ووكيل الذكاء الاصطناعي في كل خطوة من خطوات العملية”. يتيح هذا الشرط دراسة كيف يؤثر مدى “التدخل البشري” على جودة العمل العلمي النهائي.

تخفيف العبء: ضرورة مراجعة الذكاء الاصطناعي في ظل “انفجار البحوث“

على الرغم من الجدل، يرى مؤيدو استخدام الذكاء الاصطناعي في التحكيم أنه أصبح ضرورة ملحة، خاصة في مجال علوم الحاسب. يعزو زو وزملاؤه ذلك إلى “الانفجار الهائل في المنشورات” (Explosion of Publications). فقد تضاعف عدد الأوراق المقدمة لمؤتمر نيوريبس (NeurIPS) بأكثر من الضعف في السنوات الخمس الماضية، ويرجع ذلك جزئياً إلى سهولة استخدام نماذج اللغة الكبيرة في توليد الأبحاث.

الباحثة كليمنتين فوريير في “هاجينج فيس” ترى أن مؤتمراً مثل Agents4Science يمكن أن “يُحوّل بعضاً من تضخم الذكاء الاصطناعي لتخفيف عبء المراجعة” في المؤتمرات الأخرى.

يقترح زو أن الحل قد يكمن في تشكيل “فرق مراجعة هجينة” (Hybrid Review Teams) تجمع بين البشر ووكلاء الذكاء الاصطناعي. فمع الزيادة المذهلة في حجم الأبحاث، “بدأ الناس يدركون أننا بحاجة إلى مساعدة” لتنفيذ عملية المراجعة (التحكيم) التي تستنزف وقت الباحثين الأكفاء.

ومع ذلك، تبقى القدرة على تقييم “الحداثة” (Novelty) و”الأهمية” (Significance)، وهما معياران أساسيان في التحكيم العلمي، لصالح البشر حالياً. يشير عالم الحاسب ماثيو جومبولاي من معهد جورجيا للتكنولوجيا إلى أن الدراسات الحالية تظهر أن نماذج اللغة الكبيرة ليست بنفس جودة البشر في تقييم هذين المعيارين. ويقترح تجربة أكثر صرامة تتمثل في تعيين الأوراق عشوائياً لمراجعة بشرية أو آلية في مؤتمر قائم، ومن ثم مراقبة أي مسار يؤدي إلى “اختراقات ذات أهمية أكبر”.

يمثل مؤتمر Agents4Science 2025 حدثاً علمياً رائداً يضع الذكاء الاصطناعي، في صورة “الوكلاء” (Agents)، في صميم عمليتي تأليف ومراجعة (تحكيم) الأوراق البحثية، بهدف دراسة إمكانات وقصور العلماء الآليين. المنظمون، وعلى رأسهم جيمس زو، ينظرون إليه كـ “بيئة اختبار” لفهم كيف سيغير الذكاء الاصطناعي مستقبل النشر العلمي. وعلى الرغم من الفرص التي يقدمها المؤتمر لمواجهة تضخم الأبحاث وتخفيف عبء التحكيم على الباحثين البشر، تُحذر مارجريت ميتشل من ضرورة التعمق في فهم نقاط ضعف الوكلاء الآليين، كقابلية ارتكاب “الإيجابيات الخاطئة” والوقوع في ثغرات التحكيم، مما يؤكد الحاجة الماسة لوضع ضمانات وسياسات أخلاقية واضحة تحكم تفاعل الذكاء الاصطناعي مع البحث العلمي.

إن إطلاق مؤتمر Agents4Science ليس مجرد فضول علمي، بل هو بمثابة جرس إنذار وتحفيز للمجتمع الأكاديمي والجمهور العام على حد سواء. إنه يؤكد أننا تجاوزنا مرحلة استخدام الذكاء الاصطناعي كأداة فحسب، ودخلنا مرحلة الشريك الفعّال في إنتاج وتقييم المعرفة. وللحفاظ على “الأمانة والدقة العلمية“، وهي الركيزة الأساسية للبحث، يجب أن تتضافر جهود الباحثين في الذكاء الاصطناعي والخبراء في أخلاقياته لوضع أطر عمل تقييمية شفافة وموثوقة. إن المستقبل العلمي قد يشهد فرق مراجعة “هجينة“ تجمع بين الكفاءة الآلية والحكمة البشرية، وهو التوازن الذي سيحدد مدى جودة الأجيال القادمة من الاكتشافات العلمية.

سعدنا بزيارتك، جميع مقالات الموقع هي ملك موقع الأكاديمية بوست ولا يحق لأي شخص أو جهة استخدامها دون الإشارة إليها كمصدر. تعمل إدارة الموقع على إدارة عملية كتابة المحتوى العلمي دون تدخل مباشر في أسلوب الكاتب، مما يحمل الكاتب المسؤولية عن مدى دقة وسلامة ما يكتب.

التعليقات :