حقق باحثون في جامعة ولاية كارولينا الشمالية ما كان يُعتقد أنه مستحيل. حيث سرقوا نموذج ذكاء اصطناعي (AI) دون اختراق الجهاز الذي كان يعمل عليه النموذج. إن هذه التقنية لسرقة نماذج الذكاء الاصطناعي لها آثار بعيدة المدى على أمن نماذج الذكاء الاصطناعي.

تمكن الباحثون من سرقة المعلمات الفائقة لنموذج الذكاء الاصطناعي الذي يعمل على وحدة معالجة Google Edge Tensor (TPU)، دون أي معرفة مسبقة بالبرنامج أو البنية الداعمة للذكاء الاصطناعي. وهذا يعني أنهم كانوا قادرين على تحديد البنية والخصائص المحددة لنموذج الذكاء الاصطناعي، وحتى إعادة إنشاء الميزات عالية المستوى للذكاء الاصطناعي.

ولهذه التقنية آثار كبيرة على أمن نماذج الذكاء الاصطناعي، لأنها تسمح للمهاجمين بسرقة ملكية فكرية قيمة والإضرار بالميزة التنافسية لمطوري النموذج. علاوة على ذلك، يمكن لنماذج الذكاء الاصطناعي المسربة أن تكشف البيانات الحساسة المضمنة في سلوك النموذج، مما يجعلها عرضة للهجمات.

محتويات المقال :

قيمة نماذج الذكاء الاصطناعي

أصبحت نماذج الذكاء الاصطناعي (AI) العمود الفقري للعديد من الصناعات. تم بناء هذه النماذج على خوارزميات معقدة، وكميات هائلة من البيانات، وموارد حسابية كبيرة. ولكن ما الذي يجعلها ذات قيمة كبيرة؟

تكمن الإجابة في قدرتهم على التعلم من البيانات، والتحسن بمرور الوقت، واتخاذ تنبؤات أو قرارات دقيقة. يمكن لنماذج الذكاء الاصطناعي تحليل الصور الطبية للكشف عن الأمراض، والتعرف على الكلام لتحسين المساعدين الصوتيين، وحتى قيادة السيارات بشكل مستقل. ولا تكمن قيمة هذه النماذج في أدائها فحسب، بل تكمن أيضًا في البيانات المستخدمة لتدريبها والملكية الفكرية التي تدخل في إنشائها.

في عالم الذكاء الاصطناعي، البيانات هي النفط الجديد. حيث تستثمر الشركات والمؤسسات بكثافة في جمع البيانات وتصنيفها ومعالجتها لبناء نماذج دقيقة. يمكن أن تكون تكلفة بناء نموذج الذكاء الاصطناعي باهظة، حيث تتراوح التقديرات من عشرات الآلاف إلى ملايين الدولارات. علاوة على ذلك، فإن الوقت والخبرة اللازمة لتطوير النموذج وتدريبه يمكن أن يستغرق شهورًا أو حتى سنوات.

ومع وجود الكثير على المحك، فلا عجب أن يصبح أمن نماذج الذكاء الاصطناعي مصدر قلق متزايد. يمكن أن يتم تسريب النماذج أو سرقتها أو اختراقها، مما يؤدي إلى كشف البيانات الحساسة والملكية الفكرية. يمكن أن يكون لسرقة نموذج الذكاء الاصطناعي عواقب بعيدة المدى، بما في ذلك فقدان الميزة التنافسية، والإضرار بالسمعة، وحتى المسؤولية القانونية.

كيف يمكن للإشارات الكهرومغناطيسية سرقة نماذج الذكاء الاصطناعي؟

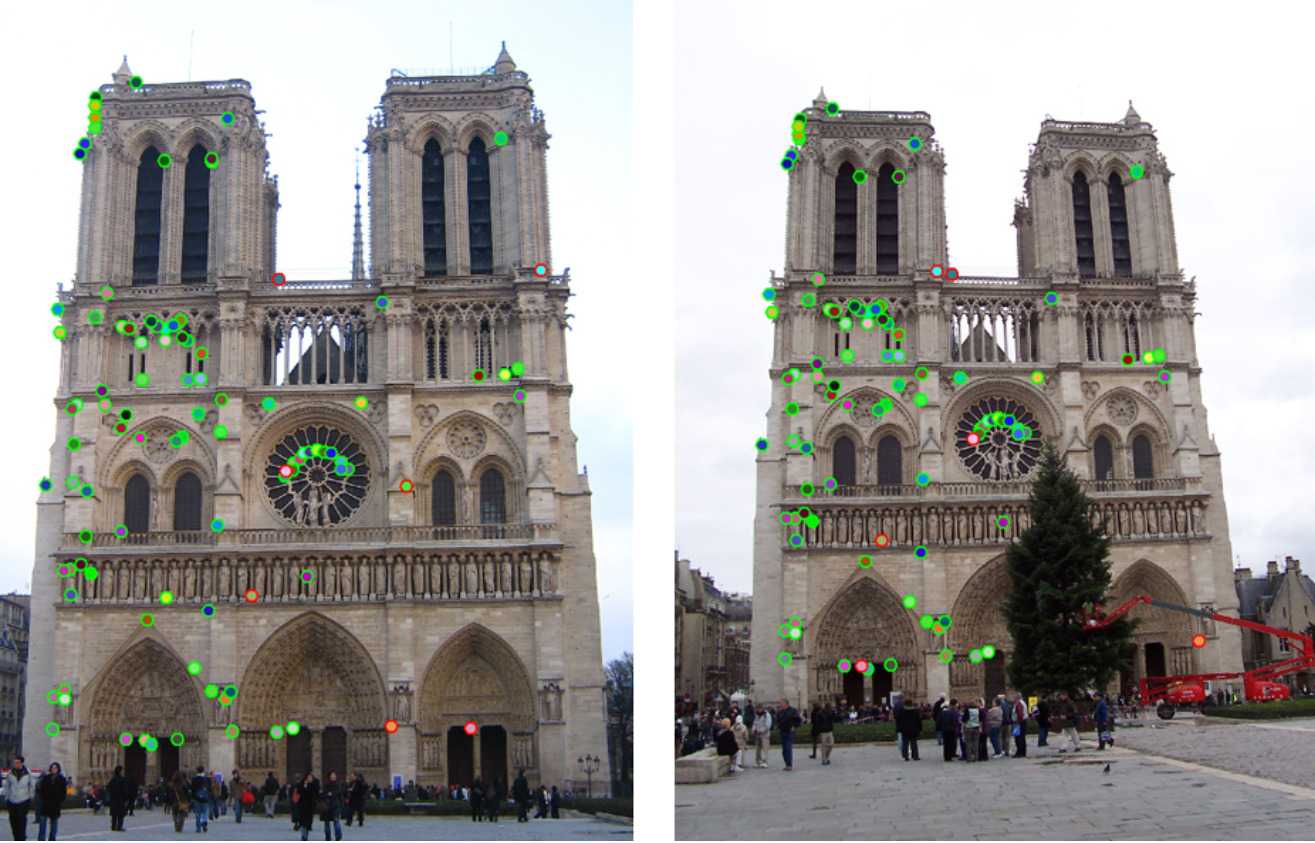

يكمن سر نجاح الباحثين في مراقبة الإشارات الكهرومغناطيسية المنبعثة من شريحة وحدة معالجة المُوَتِّر (Tensor Processing Unit) الخاصة بـ “Google Edge”. تكشف هذه الإشارات، مثل بصمة الإصبع الفريدة، عن بنية نموذج الذكاء الاصطناعي وتفاصيل طبقاته.

ومن خلال وضع مسبار كهرومغناطيسي أعلى الشريحة، تمكن الباحثون من التقاط البيانات في الوقت الفعلي حول التغيرات في المجال الكهرومغناطيسي أثناء معالجة الذكاء الاصطناعي. ثم تمت مقارنة هذا “التوقيع الكهرومغناطيسي” بقاعدة بيانات لتوقيعات نماذج الذكاء الاصطناعي الأخرى التي تم إجراؤها على جهاز مماثل. وهذا مكنهم من إعادة إنشاء نموذج الذكاء الاصطناعي.

إعادة إنشاء نموذج دون معرفة توقيعه مسبقًا

طور الباحثون تقنية جديدة لسرقة نماذج الذكاء الاصطناعي، حتى بدون معرفة مسبقة ببنيتها المحددة. تتضمن هذه الطريقة تحليل الإشارات الكهرومغناطيسية التي ينبعثها الجهاز الذي يشغل نموذج الذكاء الاصطناعي.

في البداية، يقدر الباحثون عدد الطبقات في النموذج المستهدف. يوفر هذا إطارًا لتحليلهم اللاحق. بدلاً من محاولة تحليل توقيع النموذج بالكامل مرة واحدة، يقومون بتقسيمه طبقة تلو الأخرى. من خلال القيام بذلك، فإنهم يقللون بشكل كبير من التعقيد الحسابي للعملية.

يمتلك الباحثون قاعدة بيانات ضخمة من توقيعات الطبقات من نماذج الذكاء الاصطناعي المختلفة. يقارنون توقيع الطبقة الأولى من النموذج المستهدف بهذه القاعدة البيانات لتحديد أقرب تطابق. بمجرد إجراء هندسة عكسية للطبقة الأولى، يستخدمون هذه المعلومات لتحسين بحثهم عن توقيع الطبقة الثانية. تستمر هذه العملية التكرارية حتى يتم تحديد جميع الطبقات وإعادة بناء بنية النموذج بالكامل.

وأظهر الباحثون في عرضهم التوضيحي أن هذه التقنية كانت قادرة على إعادة إنشاء نموذج الذكاء الاصطناعي المسروق بدقة تصل إلى 99.91%.

حماية نماذج الذكاء الاصطناعي من السرقة والضعف

يثير نجاح هذه التقنية مخاوف كبيرة بشأن أمان نماذج الذكاء الاصطناعي. ومع تزايد انتشار الذكاء الاصطناعي في كل مكان، أصبحت الحاجة إلى حماية هذه الأصول القيمة من السرقة والاستغلال أكثر أهمية من أي وقت مضى.

وتسلط الثغرة الأمنية التي أظهرها هذا البحث الضوء على الحاجة إلى اتخاذ تدابير أمنية قوية لمنع سرقة نماذج الذكاء الاصطناعي. حيث يجب على المطورين إعطاء الأولوية لحماية نماذجهم، باستخدام تقنيات مثل التشفير والتخزين الآمن للبيانات وعناصر التحكم في الوصول لمنع الوصول غير المصرح به.

علاوة على ذلك، يؤكد هذا البحث على أهمية حماية الملكية الفكرية في عصر الذكاء الاصطناعي. ومع تزايد قيمة نماذج الذكاء الاصطناعي، فإن الحاجة إلى الحماية ضد السرقة والاستغلال سوف تشتد.

المصادر

Researchers demonstrate new technique for stealing AI models | eurekalert

سعدنا بزيارتك، جميع مقالات الموقع هي ملك موقع الأكاديمية بوست ولا يحق لأي شخص أو جهة استخدامها دون الإشارة إليها كمصدر. تعمل إدارة الموقع على إدارة عملية كتابة المحتوى العلمي دون تدخل مباشر في أسلوب الكاتب، مما يحمل الكاتب المسؤولية عن مدى دقة وسلامة ما يكتب.

التعليقات :